CPU, GPU, NPU, TPU

인공지능(AI) 개발에 필수적인 머신러닝에는 GPU, NPU, TPU 등의 프로세싱 칩이 사용되고 있다.

많다 복잡하다. 내가 아는 것은 CPU, GPU...

각각의 차이점을 알기 쉽지 않다.

구글과 클라우드 스토리지 서비스를 제공하는 ‘Backblaze’가 CPU, GPU, NPU, TPU의 차이점을 정리했다.

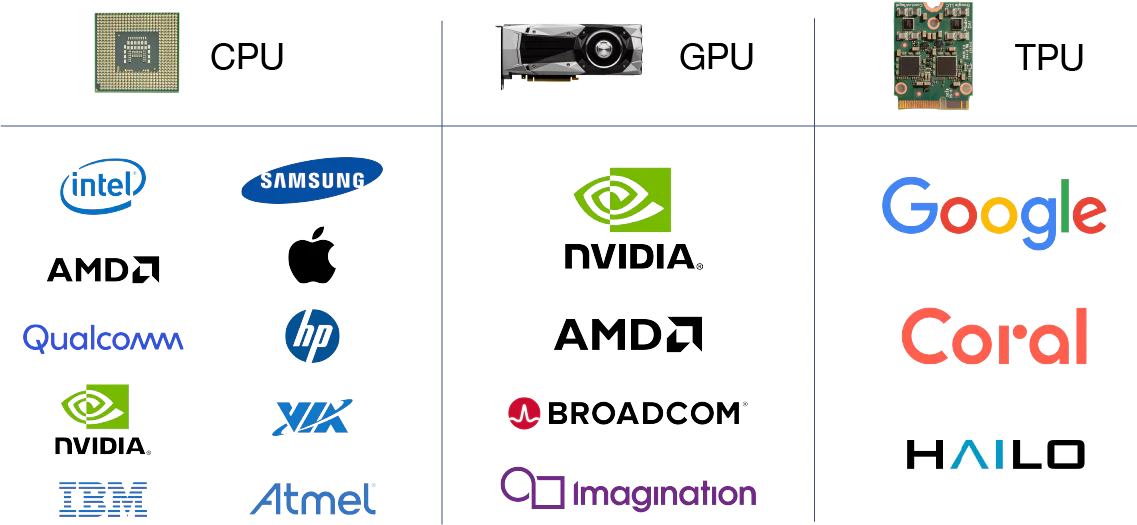

CPU

Central Processing Unit

PC에서 문서 작성, 로켓의 경로 계산, 은행의 거래 처리 등 다양한 용도로 사용되고 있다. CPU에서도 기계학습을 실시하는 게 가능하지만 계산할 때마다 메모리에 접속하는 특징이 있어, 기계학습에 필요한 대량의 계산을 실행할 때에는 메모리 통신 속도가 병목현상이 돼 처리속도가 느려진다.

GPU

Graphics Processing Unit

GPU와 메모리, 입출력 장치 등을 세트로 구성한 그래픽 보드가 시중에 널리 유통되고 있으며, GPU에는 수천 개의 산술논리연산유닛(ALU)이 탑재돼 '량의 연산을 동시에 수행하는 처리가 CPU에 비해 압도적으로 빠른 기계학습이 가능하다. 하지만 GPU는 게임이나 CG 처리 등에도 활용할 수 있는 범용 칩이기 때문에 머신러닝 전용으로 설계된 칩에 비해 효율이 떨어진다.

NPU

Neural Processing Unit

Neural network Processing Unit

GPU와 마찬가지로 대량의 연산을 동시에 수행하는 처리에 특화되어 있다. 또한, NPU는 머신러닝 전용으로 설계된 칩이기 때문에 GPU보다 더 효율적으로 연산을 수행할 수 있다. 반면 NPU는 머신러닝 전용 설계 칩이기 때문에 CPU나 GPU처럼 다양한 용도로 사용할 수 없다는 단점이 있다.

최근 출시되는 스마트폰에는 NPU를 탑재한 제품들이 많이 등장하고 있으며, 아이폰 시리즈에는 ‘Neural Engine’이라는 이름으로 탑재되어 있고, 스마트폰용 SoC인 ‘스냅드래곤(Snapdragon)’에도 NPU를 탑재한 모델이 존재한다.

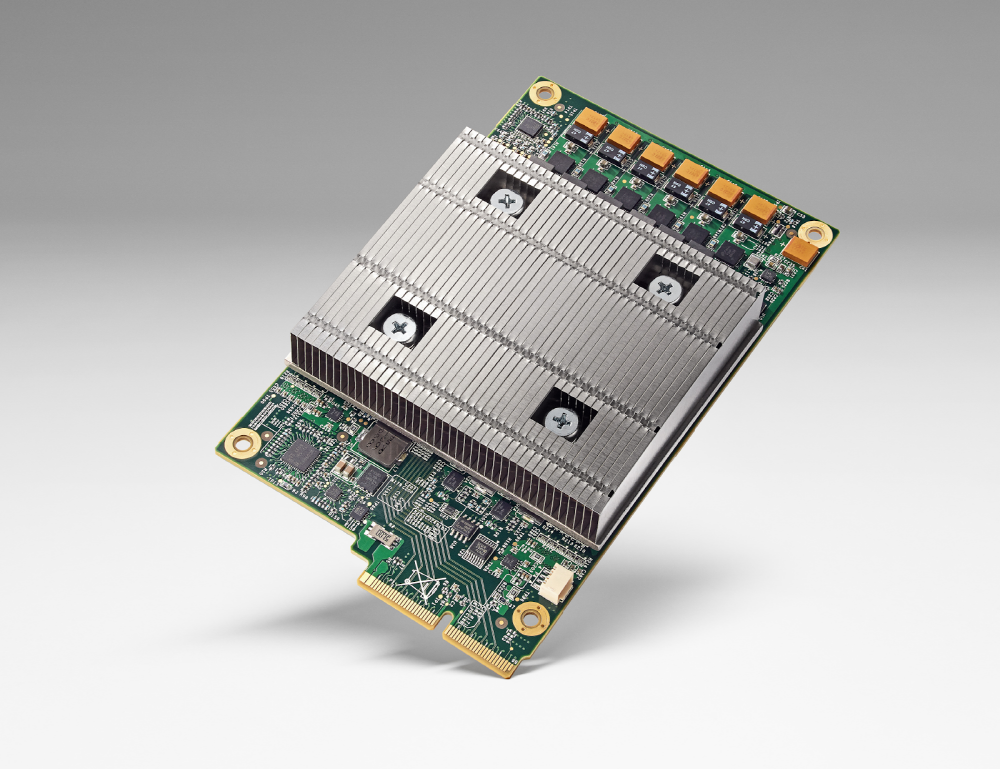

TPU

Tensor Processing Unit

구글이 개발한 NPU의 일종이다. 구글은 클라우드 컴퓨팅 서비스 ‘Google Cloud’를 통해 사용자에게 TPU의 처리 능력을 제공하고 있다. 사용자는 스스로 하드웨어를 준비하지 않아도 머신러닝 관련 처리를 고효율로 수행할 수 있다.

구글은 자사가 제공하는 ‘TPU v4’가 엔비디아의 머신러닝 관련 처리 특화 GPU ‘A100’보다 1.2~1.7배 빠르고, 전력 효율도 1.3~1.9배 우수하다고 주장하고 있다.

독일 헬름홀츠 제공, 3년뒤 오염수 방류 시물레이션

그린피스 측 의견 방사성 핵종이 포함된 오염수가 바다에 방류된다면 해양 생태계에서도 계속 확산을 거듭하게 될 것. 수산물을 통해 방사성 물질이 인체 내부에 쌓여 세포 조직을 파괴하는 일

phillipoh.tistory.com

80년대에 상상했던 미래의 AI

매킨토시 128K 1984년 스티브잡스는 애플 매킨토시를 세상에 선보였다. GUI OS와 유선 마우스를 전세계에 알려 오늘날의 컴퓨터 형태를 만들어낸다. Macintosh 128K로 브랜드가 변경된 Apple Macintosh 는 최

phillipoh.tistory.com

슬픈 천재 IT기업 '제록스' (XEROX)

모방은 창조의 어머니 위대한 스티브잡스는 팔로알토의 IT기업 제록스에서 GUI를 호로록 훔쳐 도용하여 MacOS를 만들어 냈다. 물론 빌 게이츠는 그 맥OS를 허락도 없이 카피해서 윈도우즈를 만들었

phillipoh.tistory.com

애드센스 gstatic.com 은 무엇일까?

'gstatic.com' 은 무엇인가요? 누군가 내 애드센스 사이트를 훔쳐보는겐가? 얼마전 무효클릭 이놈 때문인가? 어느 날 애드센스 관리자 화면에서 본인이 관리하는 사이트가 아닌 gstatic.com에서 수입이

phillipoh.tistory.com

스티브 잡스 vs 빌 게이츠

우리가 일반적으로 스티브잡스는 롤모델이면서 본받아야하는 1순위 형님. 빌게이츠는 돈밖에 모르는 촌놈.. 이라고 알고 있다. 그냥 재미삼아 정리된 짤이지만 사실은 아래에 잘 정리되어 있다.

phillipoh.tistory.com

'AI시대가 온다' 카테고리의 다른 글

| 2024년 AI 특이점(Singularity) 온다. (56) | 2024.04.22 |

|---|---|

| AI를 개발하는 AI개발자 '데빈 Devin' (1) | 2024.04.04 |

| 오픈AI, GPT-5 (2024년 여름) 출시 예상 (12) | 2024.04.01 |

| 거대언어모델의 한계... 할루시네이션(Hallucinations) (8) | 2024.03.20 |

| 알리바바 컴퓨팅연구소가 공개한 생성AI 'EMO' (9) | 2024.02.29 |

| 오픈AI(Open AI) '소라(Sora)'... text로 만든 생성AI 비디오 (12) | 2024.02.21 |

| 온디바이스 AI폰 시대 '갤럭시 S24' (0) | 2024.01.18 |

| AI '미드저니' 무단 도용사실 대량 폭로 (0) | 2024.01.04 |